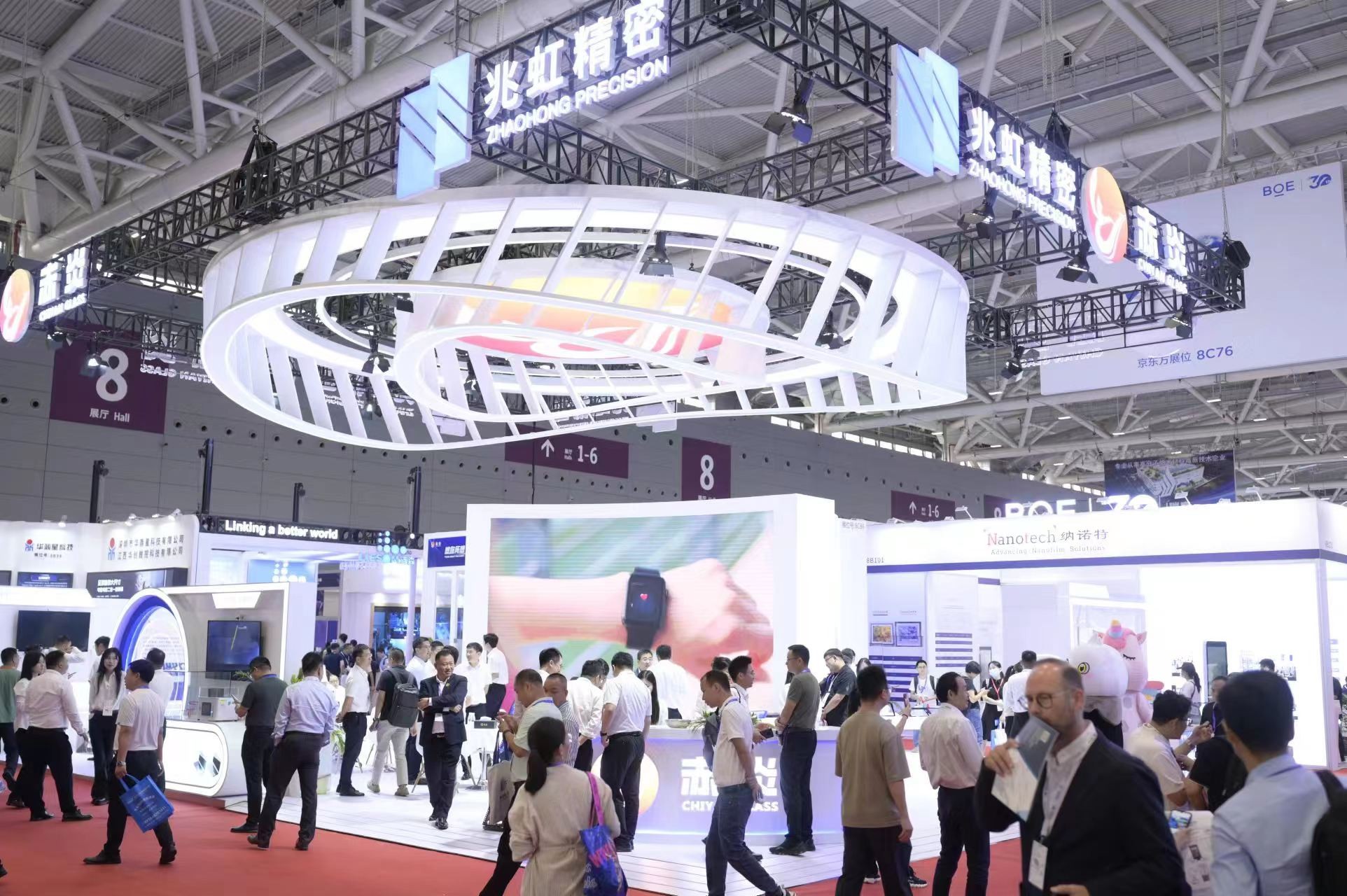

火山引擎VeDIA/B测试助力剪映APP验证新功能效果

C端产品的用户体验是决定用户留存率和产品使用率的关键。为了提升用户体验,一些C端产品上线新功能前已经开始引入A/B测试,判断新功能带来的用户反馈。本文介绍剪映APP应用A/B测试验证新功能上线效果的案例,分享C端产品通过A/B实验验证产品新功能的实践经验。

剪映APP是一款视频编辑工具,提供剪辑功能,滤镜、美颜效果,曲库等资源。随着用户规模增加,剪映希望对产品素材库进行优化,帮助视频创作者更高效地找到适配视频的贴纸素材,提升素材库的分发效率。

围绕上述目标,剪映素材团队设计了贴纸素材分发的新模型,并提出几个不同的策略方向。他们计划通过A/B测试,验证新策略的效果,验证在引入“非个性化分发模型”后,用户反馈是怎样的。

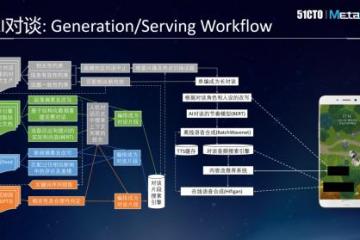

剪映此次的A/B实验将用户分为3组,随机分配到对照组V1、实验组V2、实验组V3中:

?对照组V1:不进行任何干预,按原运营人工配置贴纸内容方案进行。

?实验组V2:引入非个性化分发模型,推荐贴纸内容不打散,内容日更新

?实验组V3:引入非个性化分发模型,推荐贴纸内容打散,内容日更新

实验组中贴纸内容是否打散的含义是指类似主题的贴纸是否集中出现。“贴纸内容不打散”,意味着同类主题贴纸将按顺序集中出现,供用户选择;“贴纸内容打散”,意味着同类主题贴纸在同一个位置时,每类仅出现1-2种。

一期A/B实验的数据显示,“非个性化分发模型”策略上线后,用户在“非搜索使用”素材场景中的贴纸使用率、导出率均有显著提升,产品大盘数据也呈正向显著。这意味着新策略会提升用户使用剪映素材的意愿。因此在实验结束后,团队确定了产品的迭代方向,后续也会将对贴纸面板迭代的经验应用到其他素材面板的迭代中。

A/B实验在产品优化的过程中起着举足轻重的作用,在面对新功能上线或多策略择优的场景下,A/B实验可以成为业务“大胆假设、小心实验”的坚实后盾。像这样的A/B实验,截至2023年中,在字节跳动已经开启了240多万次,每天都有4000多个新的实验上线,在DataTester上同时运行的实验有5万多个。

火山引擎DataTester作为火山引擎数智平台VeDI旗下的核心产品,源于字节跳动长期的技术和业务沉淀。目前,DataTester已经服务了包括美的、华泰证券、博西家电、乐刻健身等知名品牌在内的上百家企业。这些企业通过不断进行的A/B测试和优化迭代,提升产品与服务质量,从而实现业务持续的优化和增长。